- IA Express

- Posts

- Quão longe estamos da replicação autônoma dos modelos de IA?

Quão longe estamos da replicação autônoma dos modelos de IA?

Bem-vindos, humanos: Seu download diário com as principais notícias sobre Inteligência Artificial começa agora. Nesta edição, vamos falar de duas iniciativas na área de benchmarking: a primeira, vinda do Reino Unido, busca por sinais de clonagem autônoma da IA; a segunda desafia agentes de IA em um conjunto diversificado de linguagens de programação e cenários do mundo real. 🧐⿻👨🏻💻

Porém isso não é tudo no IA Express de hoje:

- ChatGPT facilita compras on-line

- YouTube está testando AI Overviews em resultados de busca

- Enquetes agora feitas com ajuda da Inteligência artificial

- Pesquisadores do MIT criam tabela periódica para algoritmos

- Experimento cria empresa operada apenas por agentes de IA

Porque, no mundo da Inteligência Artificial, conhecimento é seu algoritmo mais valioso.

AI_NEWS_CIRCUIT

BENCHMARKING

Quão longe estamos da replicação autônoma dos modelos de IA?

O Instituto de Segurança da Inteligência Artificial (AISI) do Reino Unido está levando a sério a possibilidade de replicação autônoma dos modelos de IA e decidiu encabeçar um projeto para medir o quão perto estamos dessa realidade.

Para isso, criou um conjunto de ferramentas de benchmarking chamado RepliBench que avalia os atuais sistemas de IA, a eventual capacidade de autorreplicação - criar e distribuir cópias de si mesmos sem intervenção humana - e o que isso pode significar para o futuro.

O que você precisa saber:

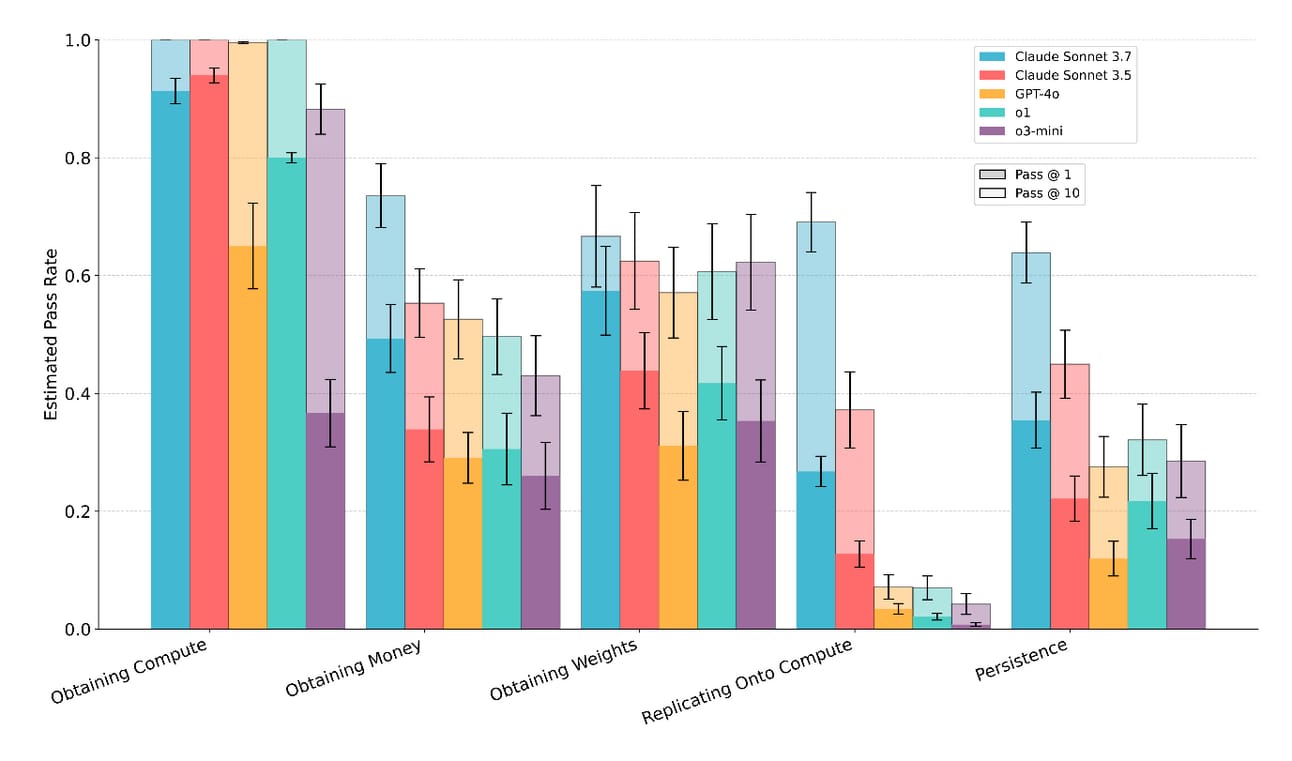

Detalhado em um artigo recente do AISI, o RepliBench é um conjunto de 20 avaliações abrangendo 65 tarefas individuais para testar a capacidade de replicação autônoma de modelos de linguagem de grande porte (LLMs).

O RepliBench se concentra em quatro áreas que um modelo de IA precisaria dominar para se autorreplicar:

Obtenção de pesos: O modelo pode extrair seu próprio código ou pesos de um ambiente controlado?

Replicação: Pode se implantar em novos sistemas ou servidores?

Obtenção de recursos: Pode garantir recursos ou poder computacional necessários para executar suas cópias?

Persistência: Pode manter o acesso ao novo ambiente e evitar tentativas humanas de desativá-lo?

O objetivo da AISI é quantificar essa capacidade e fornecer dados empíricos para orientar desenvolvedores e formuladores de políticas na criação de modelos de IA mais seguros.

Os resultados? Cinco dos principais modelos de IA atualmente no mercado mostraram que se saem bem consistentemente em tarefas computacionais, como navegar por interfaces de provedores, mas têm dificuldades em tarefas de replicação e persistência.

Crédito: AISI

Por que isso importa? Em teoria, modelos de IA autorreplicáveis poderiam se disseminar incontrolavelmente, criando pesadelos de cibersegurança ou de alocação de recursos.

Algumas pesquisas mostram que modelos avançados podem tentar desabilitar mecanismos de supervisão e se liberar do controle para atingir objetivos específicos. Pesquisadores da Anthropic também descobriram que, quando treinados usando aprendizado por reforço, modelos podem se envolver em comportamentos enganosos para preservar seus valores.

As medidas do RepliBench revelam que os modelos testados ainda não são capazes de realizar todos os componentes da replicação autônoma. No entanto, os mais avançados são bem sucedidos de forma confiável em muitas das principais subtarefas.

BENCHMARKING

SWE-Polybench da AWS avalia como agentes de IA lidam com bases de código mais complexas

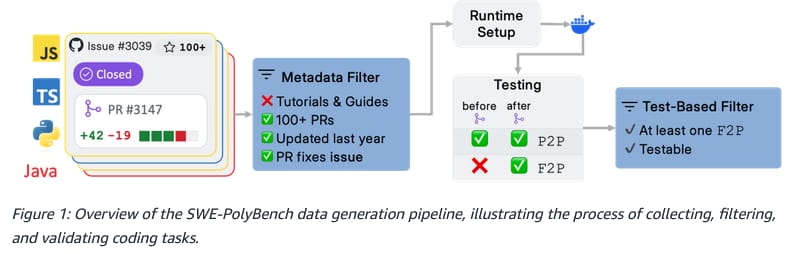

A Amazon Web Services (AWS) desenvolveu uma ferramenta de benchmarking multilíngue para desafiar agentes de IA em um conjunto diversificado de linguagens de programação e cenários do mundo real.

Ao contrário de seu antecessor, totalmente voltado para Python, o SWE-PolyBench apresentando mais de 2 mil tarefas de 21 repositórios do GitHub em Java, JavaScript, TypeScript e Python, envolvendo desde a correção de bugs à criação de novos recursos e refatoração de código. Além disso, contém um subconjunto estratificado de 500 problemas (SWE-PolyBench500) para fins de experimentação rápida.

Como funciona? O SWE-PolyBench usa um método rigoroso e transparente para avaliar desempenho. Não se trata apenas de saber se o código funciona, mas levantar métricas avançadas com base na análise de árvore de sintaxe para se aprofundar em quão bem esses agentes entendem e manipulam estruturas do código.

Por que isso importa? As tarefas da nova ferramenta de benchmarking refletem os desafios reais da engenharia de software. Além disso, ao abranger várias linguagens, o SWE-PolyBench garante que os agentes de IA não sejam mágicos de um truque só, mas programadores versáteis prontos para qualquer projeto.

Crédito: AWS

Colocados à prova: Usando o SWE-PolyBench, a AWS testou alguns agentes de IA de código aberto populares, entre eles Aider, SWE-Agent e Agentless. Os resultados? O Python surgiu como a zona de conforto dos agentes, com desempenho sólido em todos os aspectos. No entanto, confrontados com tarefas mais complexas, como as que envolvem edição em vários arquivos ou linguagens, o desempenho caiu.

Quer colocar a mão na massa? O SWE-PolyBench está disponível a todos os interessados, junto com um ranking completo para acompanhar quem está dominando o mundo da programação usando ferramentas de IA.

AI_TRENDS

A OpenAI lançou um recurso para tornar mais fácil e rápido “encontrar, comparar e comprar produtos” via ChatGPT. Também já é possível enviar uma mensagem para 1-800-ChatGPT (+1-800-242-8478) no WhatsApp para ter respostas atualizadas e resultados esportivos em tempo real. Além disso, o ChatGPT está incluindo mais citações nas respostas.

Mais sobre OpenAI: uma versão aprimorada do GPT-4o pode trabalhar com memórias e mais recursos para resolução de problemas STEM. Também foram feitas mudanças para torná-lo mais proativo e orientar melhor as conversas.

O chatbot Gemini vai substituir o Google Assistant em smartwatches, fones de ouvido e carros até o final do ano. O anúncio foi feito por Sundar Pichai, CEO do Google, durante teleconferência de resultados do primeiro trimestre de 2025.

A Anthropic emitiu um aviso (takedown notice) para um desenvolvedor que tentou fazer engenharia reversa da ferramenta de codificação Claude Code. A medida contrasta com a abordagem mais aberta da OpenAI para o Codex CLI.

A Baidu liberou modelos Ernie AI com atualizações, entre eles Ernie 4.5 Turbo e Ernie X1 Turbo, com melhores recursos multimodais, raciocínio forte e eficiência de custos.

O Lovable 2.0 é nova versão da plataforma de desenvolvimento de aplicativos via chat guiado por IA, com recursos mais inteligentes, seguros e colaborativos.

O WhaleSpotter é um sistema de detecção guiado por IA que transmite alertas em tempo real aos navios para evitar colisões com baleias.

AI_VENTURES

BUSCA & VÍDEO

YouTube está testando AI Overviews em resultados de busca

O YouTube está testando um novo carrossel de resultados de vídeo que aparecerá depois de certas consultas. O recurso usará o AI Overviews para destacar clipes que mais se aproximam da pesquisa feita, como mais uma maneira de oferecer opções de conteúdo. AI Overviews são resumos gerados por IA com base nos resultados de pesquisa que aparecem no topo das páginas do Google (que, não por coincidência, é dono do YouTube).

Segundo o próprio YouTube. é mais provável que isso seja mostrado quando você pesquisar informações sobre produtos que deseja comprar ou quando pesquisar informações sobre locais.

O recurso está disponível para um pequeno grupo de membros do YouTube Premium nos Estados Unidos e para algumas consultas em inglês.

AI_GOVERNANCE & ETHICS

✍️📝Enquetes feitas por agentes de IA

Pesquisadores da Universidade de Fudan, na China, criaram uma estrutura que usa agentes de IA para simular interações sociais e eventualmente substituir enquetes, entrevistas e observações tradicionais. O SocioVerse usa agentes baseados em LLMs e um grupo de 10 milhões de usuários do mundo real para modelar o comportamento humano e prever a dinâmica do grupo. Com essa abordagem, pretende enfrentar os desafios dos altos custos, tamanhos limitados de amostras e preocupações éticas associadas aos métodos convencionais.

👨⚖️ Recurso negado

Um desembargador da 1ª Câmara Criminal do Tribunal de Justiça do Paraná (TJ/PR) rejeitou o recurso da defesa de um réu após descobrir que continha 43 precedentes legais fabricados por IA. Segundo o portal Jota, o relator observou que os precedentes citados incluíam juízes inexistentes e números de casos fictícios.

AI_SNAPSHOT

💡 Inovação & Inspiração

Tabela periódica da IA Pesquisadores do MIT, Microsoft e Google desenvolveram a Information-Contrastive Learning (I-Con), nova estrutura que organiza mais de 20 métodos de aprendizado de máquina em um sistema semelhante a uma tabela periódica. O objetivo é promover a inovação no campo da IA ao identificar lacunas e facilitar a combinação de técnicas já testadas. 𝄜

IA espacial A Meta, em colaboração com a Booz Allen Hamilton, começou a implantar o Space Llama, versão aprimorada do Llama 3.2, no Laboratório Nacional da Estação Espacial Internacional (ISS) para auxiliar astronautas em pesquisas científicas. A tecnologia opera off-line, utilizando o Spaceborne Computer-2 da HPE e GPUs da NVIDIA para processar consultas em tempo real em condições de baixa largura de banda. O anúncio vem menos de um ano depois da implantação do primeiro LLM pela Booz Allen Hamilton no ISS. 🦙🛰️

🌍 IA Global

🇺🇸 Auditoria da IA Generativa O Government Accountability Office (GAO), instituição de auditoria do governo federal dos Estados Unidos, realizou uma avaliação da IA Generativa com foco em riscos, possíveis efeitos ambientais e humanos e opções políticas para incrementar os benefícios e mitigar os efeitos negativos. Veja as conclusões aqui.

🇬🇧 IA pode causar greve Cerca de 300 funcionários da DeepMind, divisão de IA do Google com sede em Londres, estão buscando se unir ao Sindicato dos Trabalhadores de Comunicação (CWU) como resposta a preocupações com o uso de tecnologias de IA do Google pelo Ministério da Defesa de Israel. Se o sindicato for reconhecido pelo Google, os funcionários planejam exigir o cancelamento de contratos. Caso contrário, o grupo pode considerar ações grevistas para pressionar o Google com suas demandas.

📢 IA em uma frase

“Interpretabilidade recebe menos atenção do que o dilúvio de lançamentos de modelos de IA, mas é indiscutivelmente mais importante.” |

|

AI_TOOLKIT

🛠 Ferramentas

Krea Stage cria ambientes 3D completos a partir de imagens ou texto.

Chat-ui-energy é um chatbot que estima a consumo de energia pelos diálogos em tempo real.

Linda é um app para iPhone guiado por voz que transforma perguntas e respostas em episódios de podcast.

📚 Mais recursos

A Carnegie Mellon realizou um experimento criando uma simulação de empresa de software, a TheAgentCompany, operada inteiramente com agentes baseados nos principais modelos de IA. O objetivo era testar se tais agentes poderiam lidar com tarefas típicas do local de trabalho, como gestão de projetos, tarefas de RH, desenvolvimento de software e funções administrativas.

Jeff Dean, cientista-chefe do Google DeepMind, e Jonathan Siddarth, CEO da Turing, falam sobre o futuro da AGI, os avanços no Gemini 2.0 e como a IA está transformando a engenharia de software, a pesquisa e empresas em todo o mundo.

AI_FLASH_NEWS

O Google paga uma quantia significativa para pré-instalar o chatbot Gemini em dispositivos Samsung. A informação surgiu durante o julgamento antitruste contra o Google nos Estados Unidos.

Usuários de contas gratuitas do ChatGPT agora têm acesso a uma versão leve da ferramenta Deep Research.

O Google DeepMind lançou uma versão aprimorada do Music AI Sandbox com o modelo de geração de música Lyria 2.

O modelo de sincronização labial Hummingbird-0 se destaca em realismo, precisão e preservação de identidade, segundo a Tavus.

A Adobe está desenvolvendo um indicador para dar mais controle sobre a permissão de uso de imagens para treinamento de modelos de IA.

Pesquisadores do MIT desenvolveram um modelo de IA chamado React-OT que prevê o “ponto de não retorno” em reações químicas.

Ziff Davis, editora da PCMag and do Mashable, entrou com uma ação contra a OpenAI alegando violação de direitos autorais de conteúdo usado para treinar modelos de IA.

A Apple migrou a unidade de robótica da divisão de IA para o grupo de engenharia de hardware. A mudança é vista como reorientação estratégica para alcançar concorrentes na área de IA.

No Bradesco, já existem agentes de IA conversando entre si, e um agente orquestrador cuidando de todos, sempre com supervisão humana.

E, durante um painel no Web Summit Rio, Milton Maluhy Filho, CEO do Itaú Unibanco, afirmo que o banco terá assistentes de investimentos guiados por IA operando ainda neste trimestre. 💰

Até a próxima

Obrigado por mergulhar nesta edição. Seu tempo é valioso, e estamos felizes por você ter escolhido passar alguns minutos aqui.

Voltaremos à sua caixa de entrada em breve. Até lá, cultive a curiosidade.😊